Algorithmic Bias bezieht sich darauf, dass Algorithmen, die in der Suche oder in anderen Bereichen verwendet werden, ungleiche oder ungenaue Ergebnisse liefern können, die bestimmte Stereotypen oder Vorstellungen in der Gesellschaft widerspiegeln oder verstärken.

Artikel ansehen

Zusammenfassung ansehen

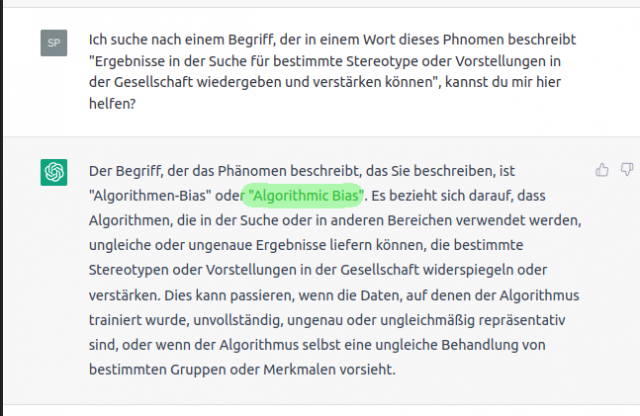

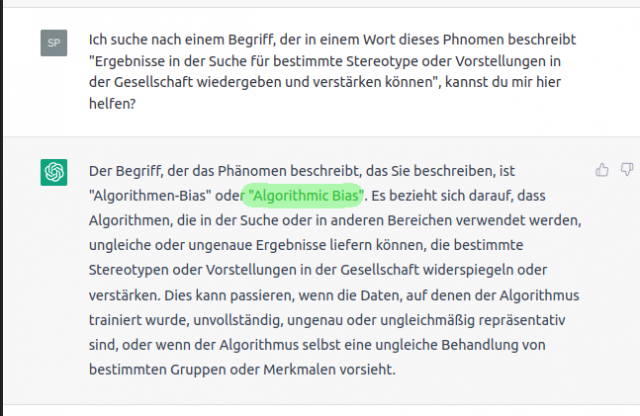

Da ich in einer Radiosendung die Aussprache auch nach wiederholtem Abspielen nicht verstanden habe, habe ich mich bei ChatGPT erkündigt:

question-for-ChatGPT: Ich suche nach einem Begriff, der in einem Wort dieses Phnomen beschreibt "Ergebnisse in der Suche für bestimmte Stereotype oder Vorstellungen in der Gesellschaft wiedergeben und verstärken können", kannst du mir hier helfen?

Mit der Antwort bin ich zufrieden:

ChatGPT-answer: Der Begriff, der das Phänomen beschreibt, das Sie beschreiben, ist "Algorithmen-Bias" oder "Algorithmic Bias". Es bezieht sich darauf, dass Algorithmen, die in der Suche oder in anderen Bereichen verwendet werden, ungleiche oder ungenaue Ergebnisse liefern können, die bestimmte Stereotypen oder Vorstellungen in der Gesellschaft widerspiegeln oder verstärken. Dies kann passieren, wenn die Daten, auf denen der Algorithmus trainiert wurde, unvollständig, ungenau oder ungleichmäßig repräsentativ sind, oder wenn der Algorithmus selbst eine ungleiche Behandlung von bestimmten Gruppen oder Merkmalen vorsieht.

question-for-ChatGPT: ChatGPT, hast du vlt. Ideen, Vorschläge, Lösungsansätze oder gar Lösungen, um die Datenbasis so aufzubereiten, um die "Algorithmic Bias"-Problematik abzuschwächen. Wie geht bspw. OpenAI mit der "Algorithmic Bias"-Problematik um?

ChatGPT-answer-begin: Es gibt verschiedene Ansätze, um die Problematik des Algorithmen-Bias zu bekämpfen. Einige dieser Ansätze, die von OpenAI und anderen Unternehmen verwendet werden, umfassen:

- Datenaufbereitung: Eine gründliche Überprüfung und Aufbereitung der Trainingsdaten kann dazu beitragen, dass ungleiche oder ungenaue Daten entfernt werden und die Daten repräsentativer für die Zielgruppe werden.

- Fairness-Metriken: Es gibt spezielle Metriken, die entwickelt wurden, um die Fairness von Algorithmen zu messen und zu bewerten. Diese Metriken können verwendet werden, um sicherzustellen, dass der Algorithmus fair behandelt und diskriminierende Ergebnisse vermieden werden.

- Diversität in Teams: Eine Vielfalt von Perspektiven und Hintergründen im Team, das an der Entwicklung des Algorithmus arbeitet, kann dazu beitragen, dass mögliche Probleme des Bias frühzeitig erkannt und behoben werden.

- Transparenz: Eine transparente Dokumentation des Algorithmus und der verwendeten Daten kann dazu beitragen, dass die Ergebnisse des Algorithmus nachvollzogen werden können und die Verantwortung für die Ergebnisse geklärt wird.

- Kontinuierliche Überwachung: Es ist wichtig, dass Algorithmen kontinuierlich überwacht werden, um sicherzustellen, dass sie weiterhin fair und genau sind.

OpenAI verfolgt einen ähnlichen Ansatz und hat einige Maßnahmen ergriffen, um sicherzustellen, dass ihre Modelle und Algorithmen fair und genau sind. Dazu gehört die Verwendung von Fairness-Metriken, die Unterstützung von Diversität und Inklusion in ihren Teams und die Schaffung von Transparenz und Nachvollziehbarkeit ihrer Modelle und Algorithmen.

Es ist wichtig zu beachten, dass die Bekämpfung von Algorithmen-Bias ein kontinuierlicher Prozess ist, der ständig weiterentwickelt werden muss, um sicherzustellen, dass Algorithmen fair und genau bleiben.

ChatGPT-answer-end: Und hier der Screenshot vom Ausschnitt aus diesem Dialog:

#

ChatGPTDiary #

AlgorithmenBias #

AlgorithmicBias #

Bias #

BiasPhänomen